Generative Engine Optimization (GEO) beschreibt die Optimierung von Inhalten, um von KI-basierten Suchmaschinen und Chatbots (wie ChatGPT, Perplexity oder Google Gemini) als Quelle ausgewählt und in deren Antworten zitiert zu werden. Während klassisches SEO darauf abzielt, in einer Liste von blauen Links weit oben zu stehen, geht es bei GEO darum, Teil der direkten Antwort der KI zu sein.

Large Language Model Optimization (LLMO): Moderne KI-Systeme wie GPT-4 nutzen umfangreiche Datensätze, um menschliche Sprache täuschend echt zu imitieren. Durch das Training mit gewaltigen Textmengen erlernen diese Modelle sowohl grammatikalische Strukturen als auch semantische Zusammenhänge. Dies ermöglicht es, präzise und kontextrelevante Inhalte zu erstellen, die individuell auf die jeweilige Nutzeranfrage zugeschnitten sind. LLMO fokussiert sich auf die Feinjustierung dieser Sprachmodelle, um sie gezielt für eigene Zwecke zu optimieren. Das ist allerdings langwierig und von ungewissem Erfolg.

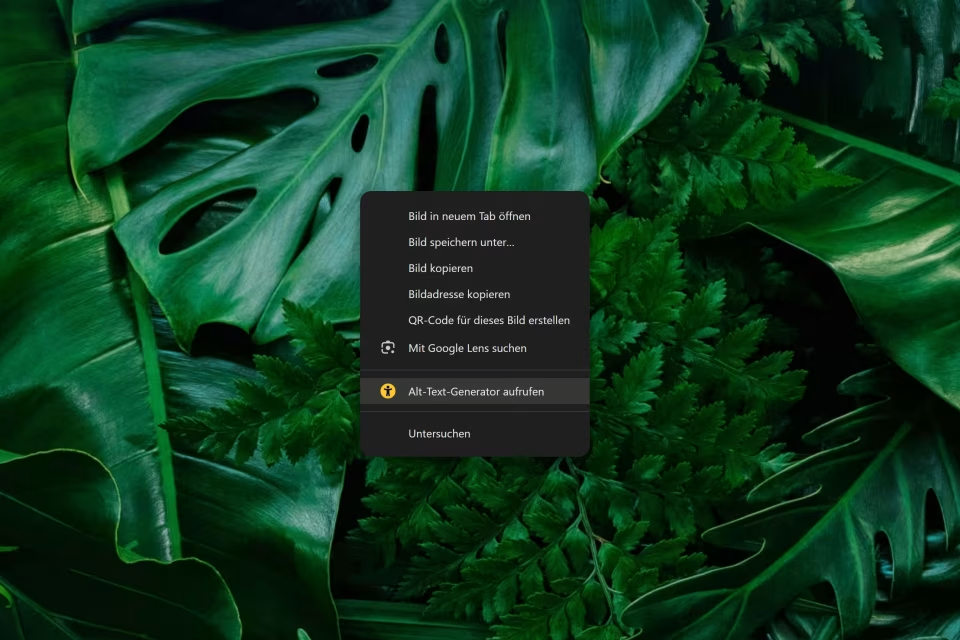

Retrieval Augmented Generation (RAG): Durch die hybride Struktur von RAG-Modellen lassen sich die Grenzen statischer Trainingsdaten überwinden. Das Modell fungiert hierbei als Bindeglied zwischen einer externen Wissensquelle und der sprachlichen Ausgabe. Indem Informationen in Echtzeit abgerufen und verarbeitet werden, liefern RAG-Systeme Antworten, die nicht nur präziser, sondern auch deutlich aktueller sind als die von Standard-Sprachmodellen. Dabei spielen klassische SEO-Kriterien eine Rolle.